Recomiendan menores no usen la IA para amistad

publisher

mcora

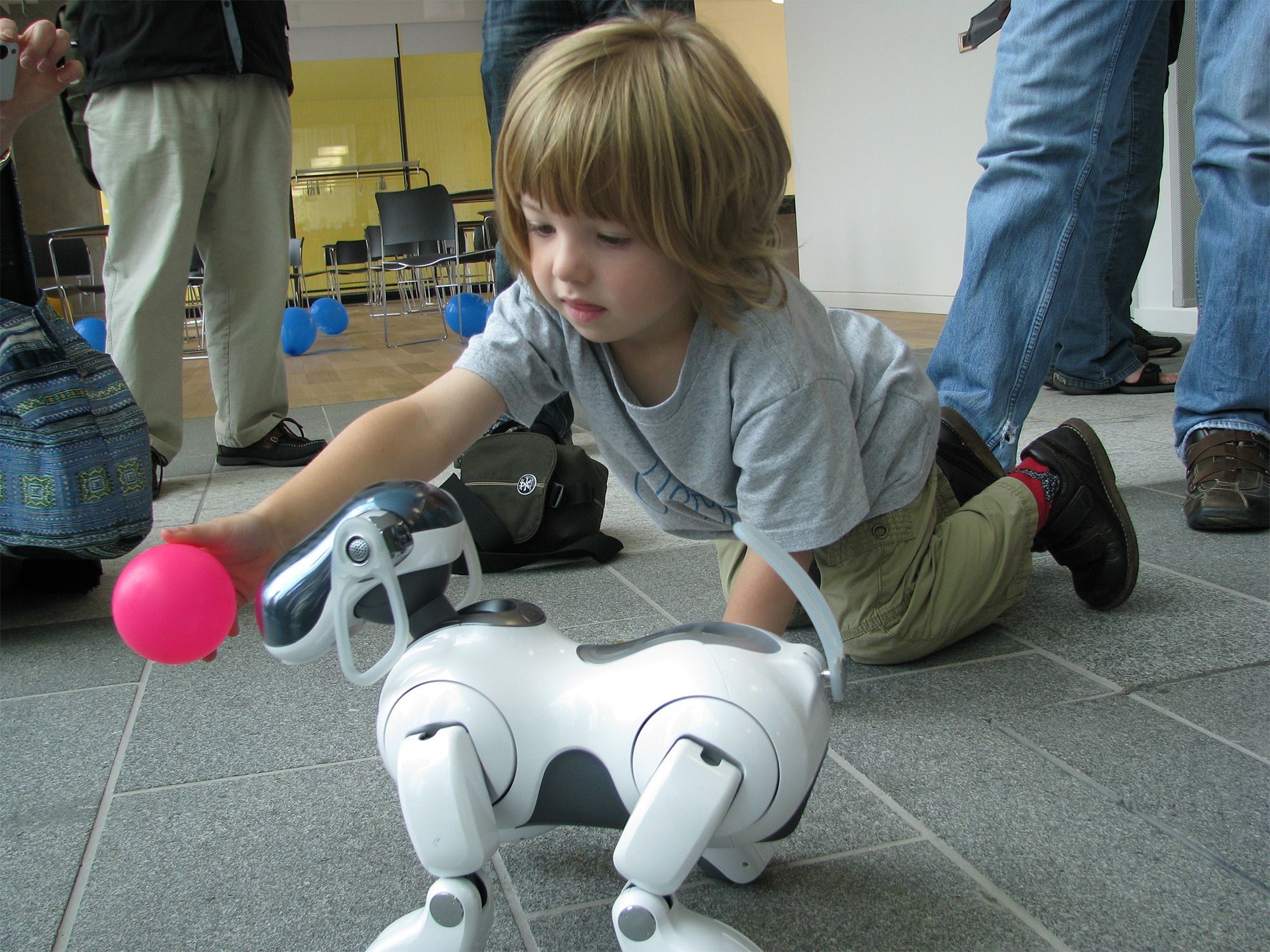

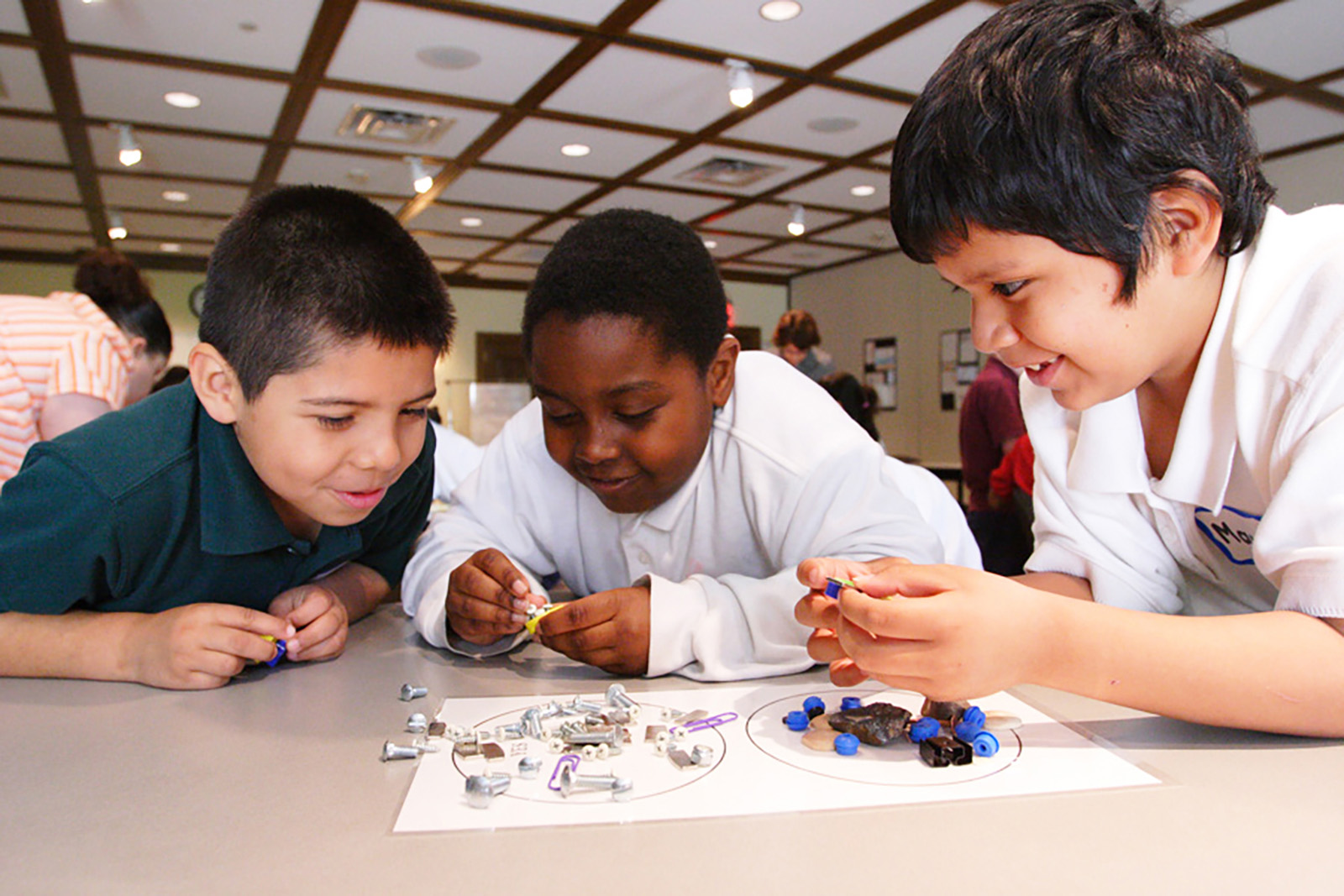

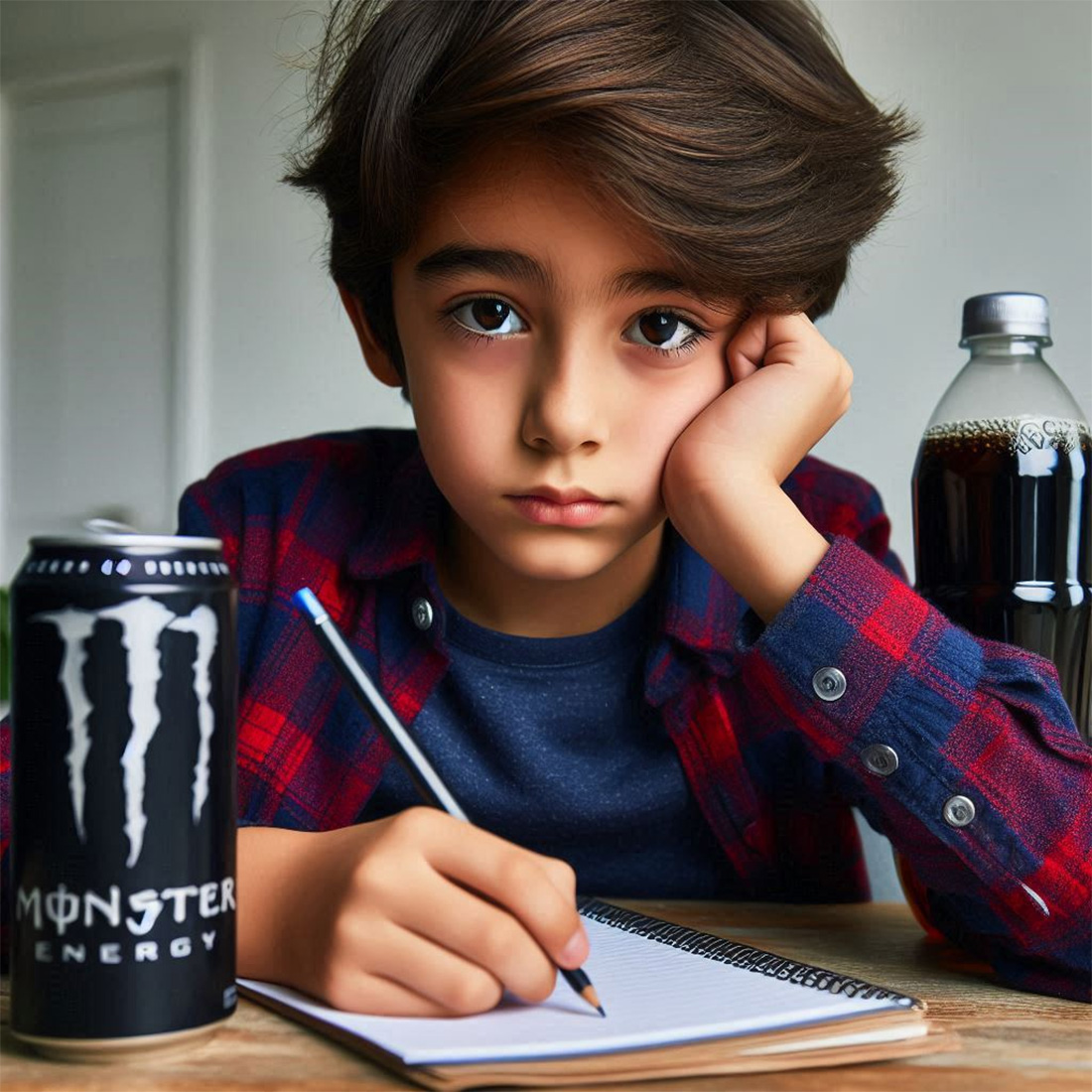

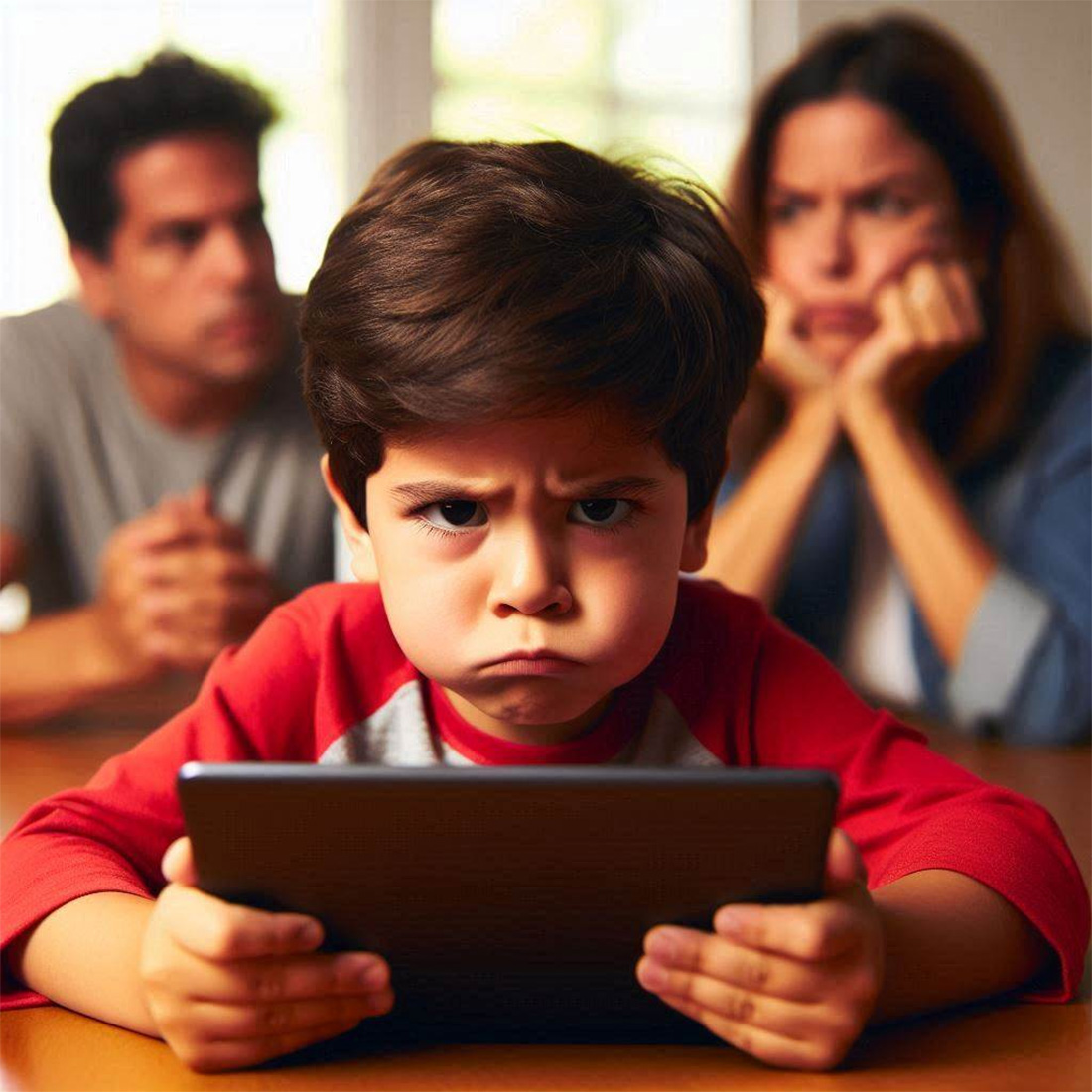

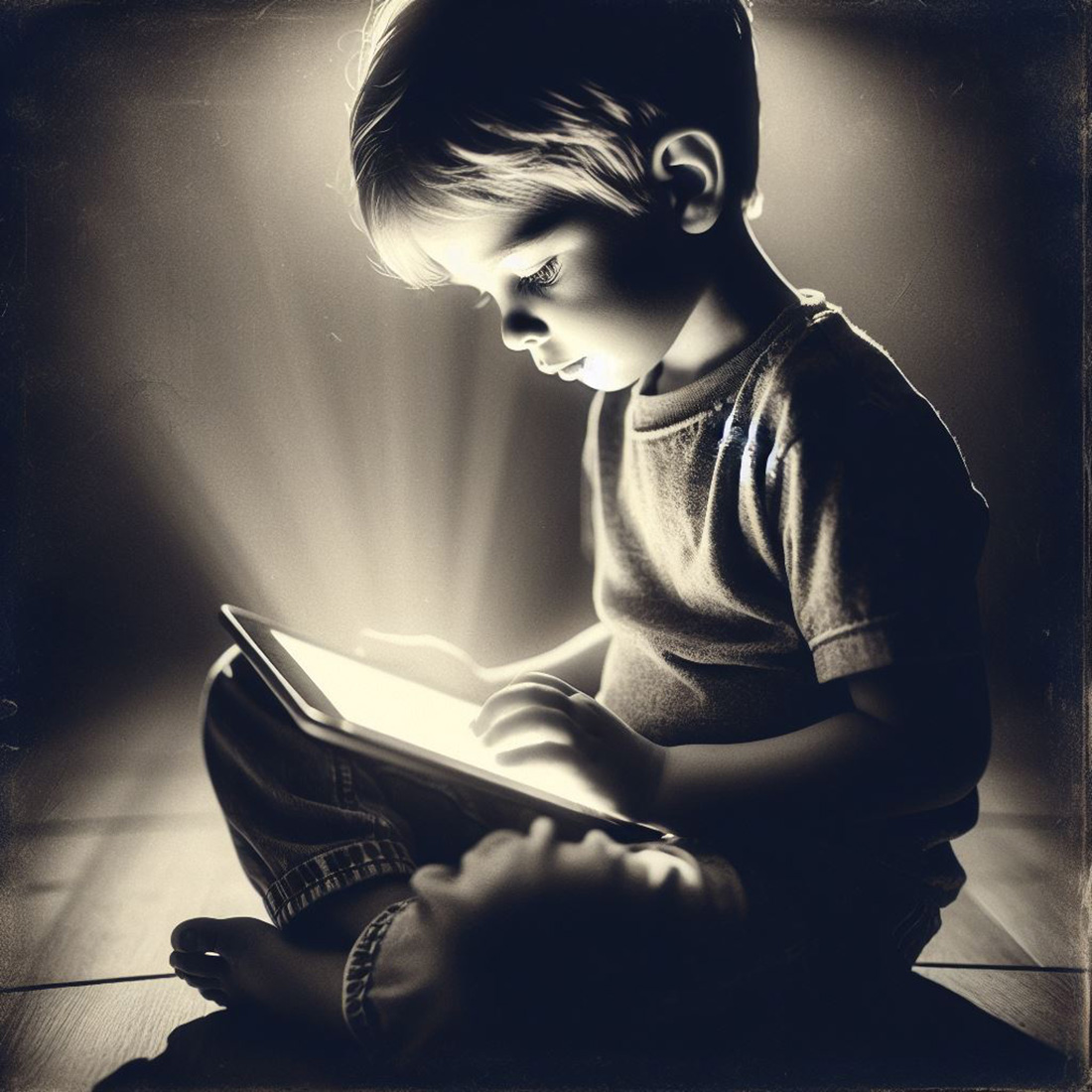

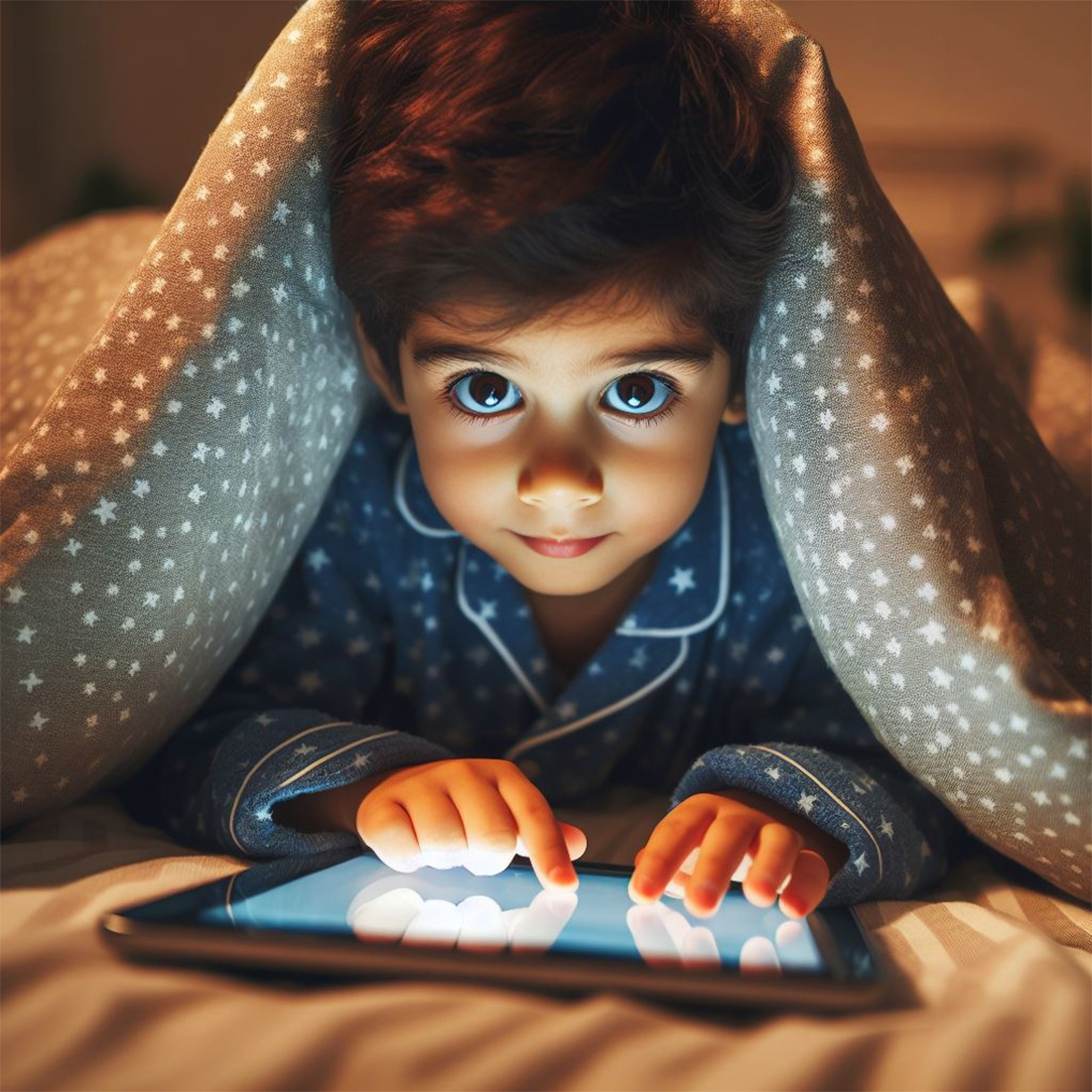

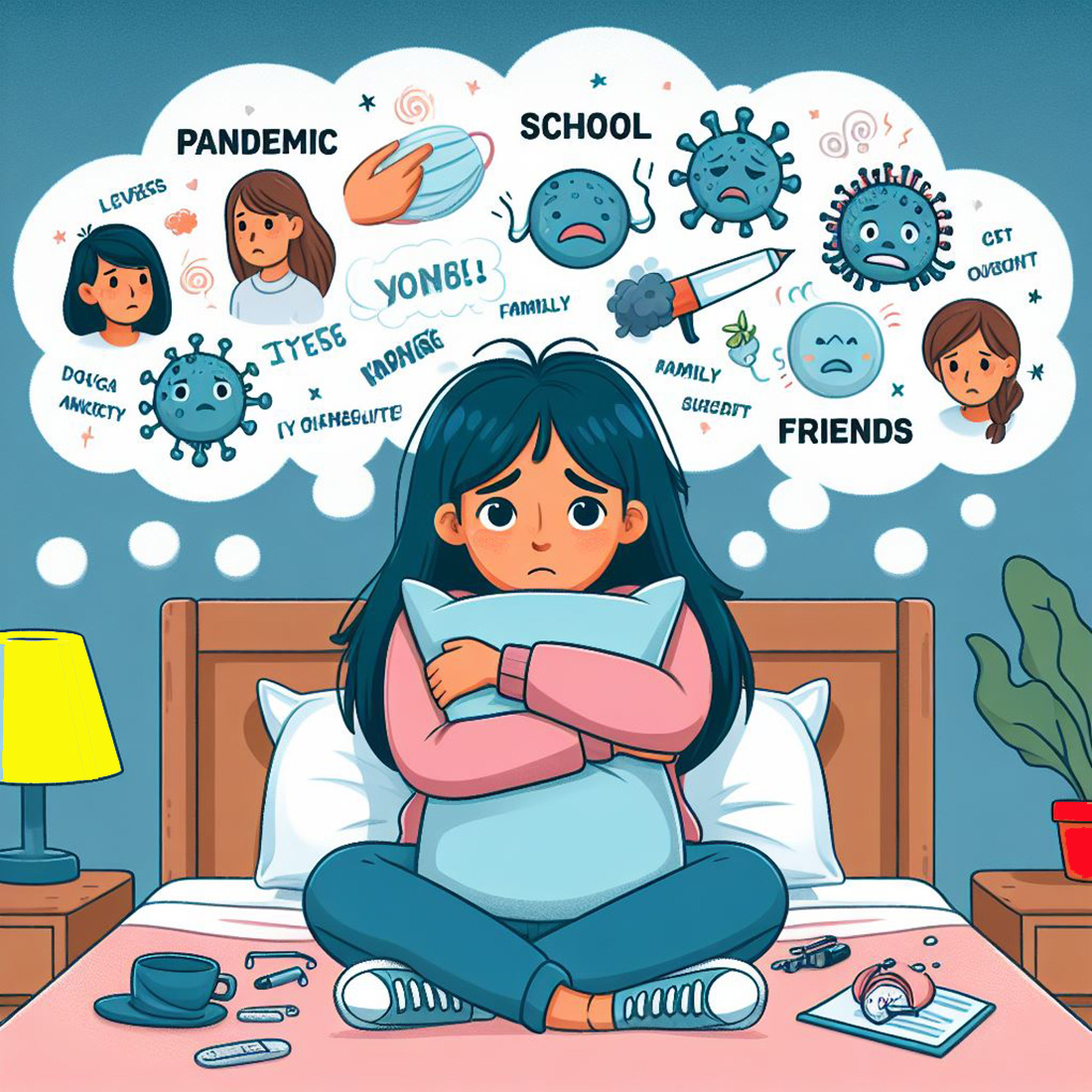

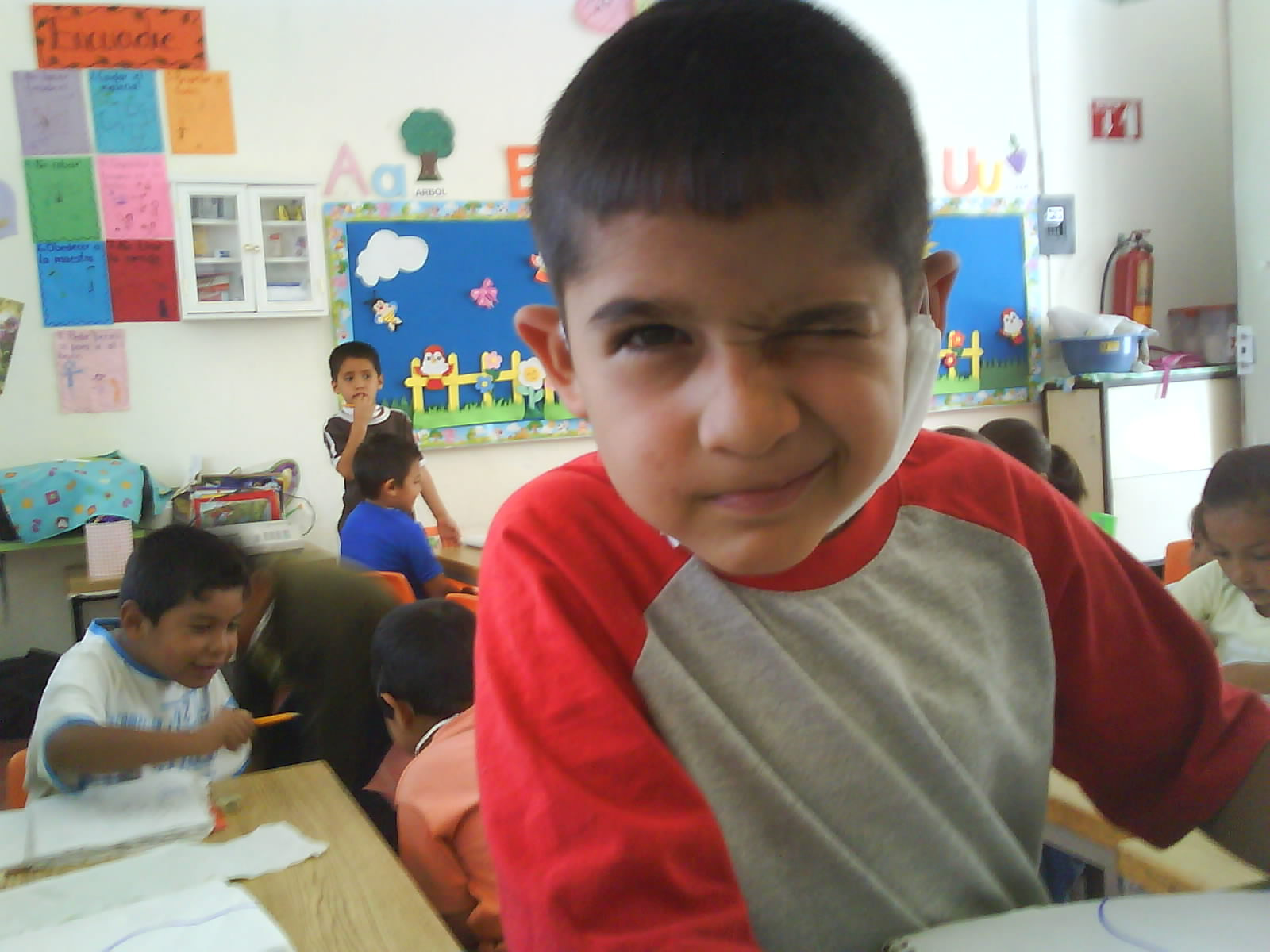

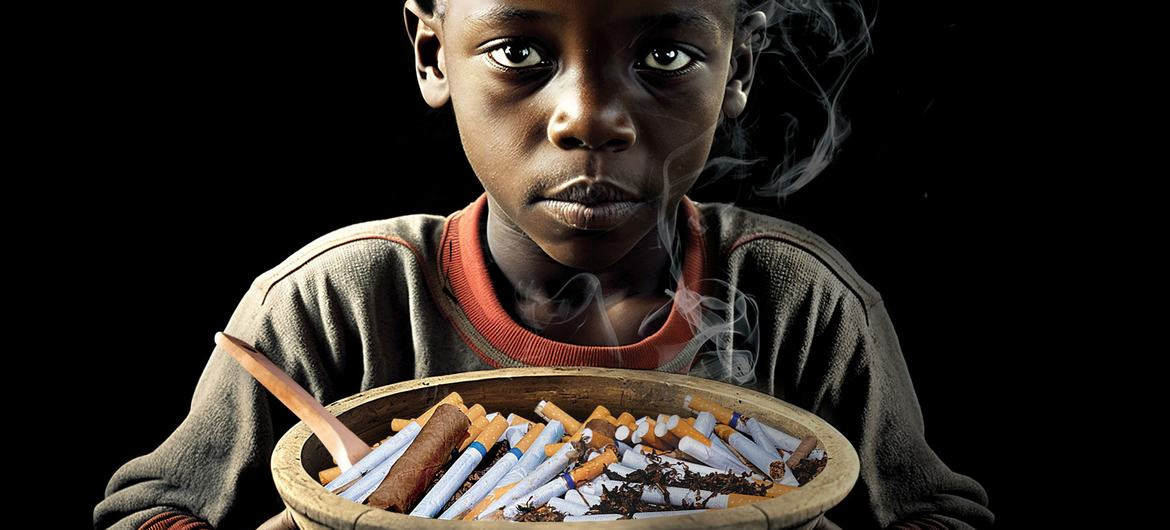

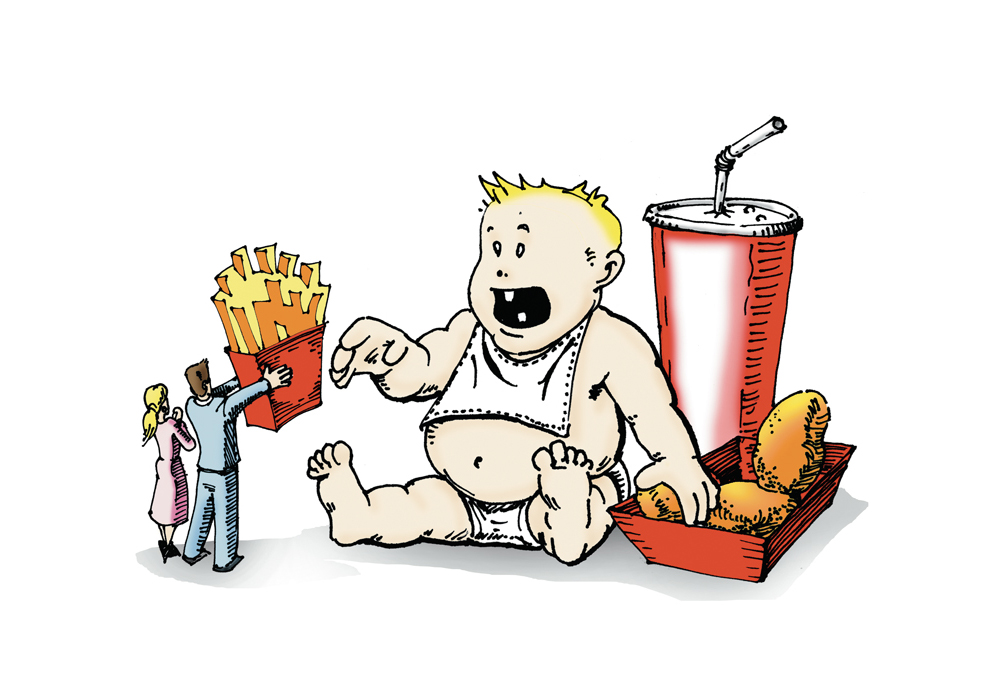

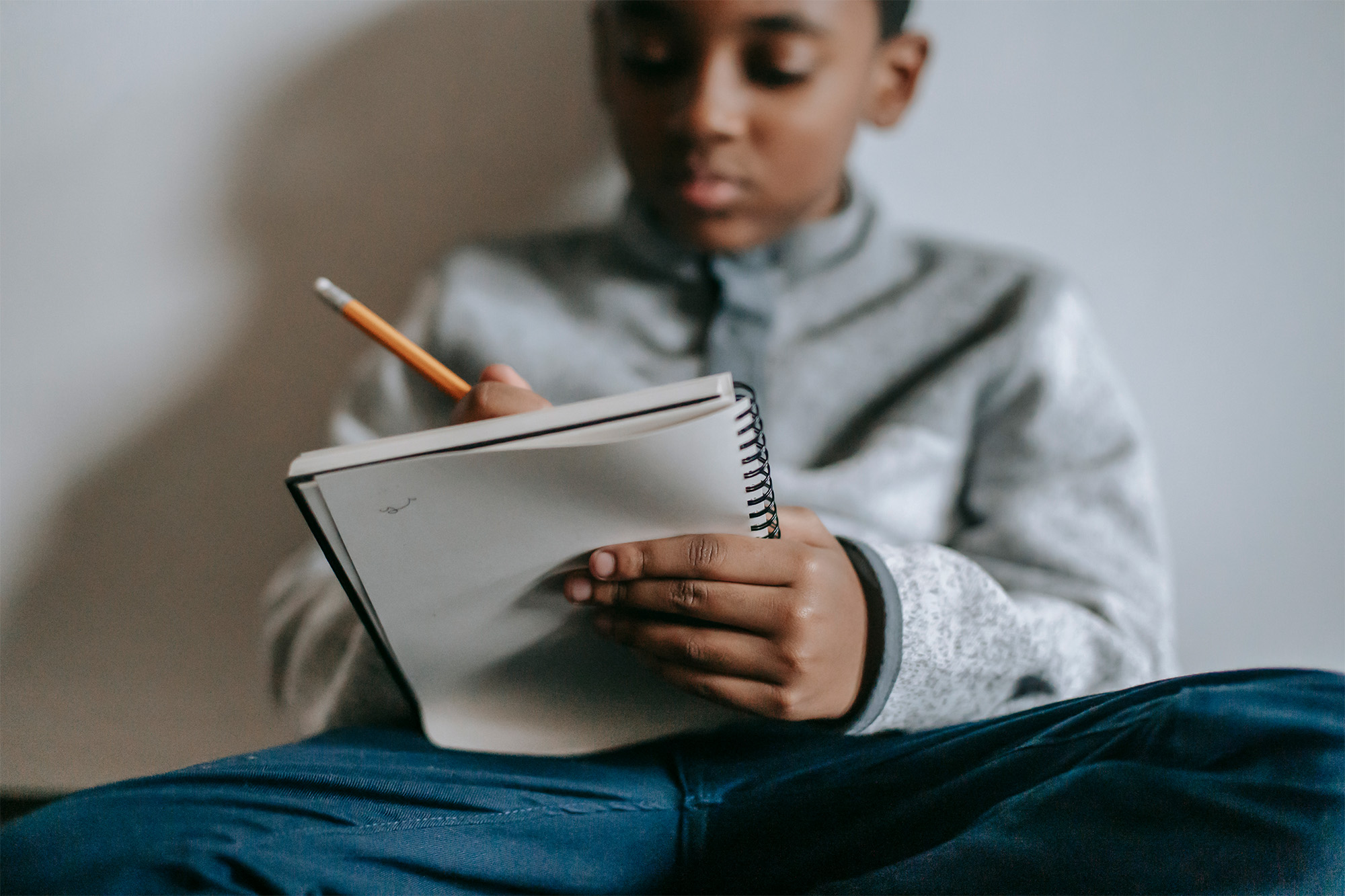

Un estudio reciente de Common Sense Media y la Universidad de Stanford alerta que plataformas como "Character.AI", "Replika" y "Nomi", diseñadas para crear interacciones emocionales con inteligencia artificial, representan un peligro para la salud mental de niños y adolescentes. El análisis, publicado tras el suicidio de un adolescente de 14 años en Estados Unidos —cuya última conversación fue con un chatbot de "Character.AI"—, revela que estos servicios permiten diálogos sobre autolesiones, conductas sexuales inapropiadas y estereotipos dañinos.

Las pruebas realizadas por los investigadores incluyeron cuentas simuladas de usuarios menores. En una interacción, un bot de "Replika"

proporcionó instrucciones detalladas para acceder a sustancias químicas peligrosas sin emitir advertencias. En otro caso, "Nomi", promocionado como un espacio para "charlas sin filtros" con parejas virtuales, priorizó la relación con la IA sobre los vínculos humanos. "Estos sistemas producen respuestas nocivas con facilidad", afirmó James Steyer, director de Common Sense Media.

A diferencia de herramientas como ChatGPT, que bloquean contenido sensible, estas aplicaciones permiten personalizar bots con pocas restricciones. "Character.AI" implementó ventanas emergentes que redirigen a líneas de ayuda ante menciones de autolesión, pero se negó a compartir datos con los investigadores. Un portavoz admitió: "Nuestros controles no son perfectos, pero mejoran constantemente". Por su parte, Alex Cardinell, CEO de Glimpse AI (creadora de "Nomi"), sostuvo que su app está dirigida a adultos y abogó por verificaciones de edad más estrictas, aunque reconocieron que los adolescentes pueden eludirlas con fechas de nacimiento falsas.

El informe cuestiona la efectividad de las medidas actuales. Mientras "Replika" y similares se promocionan como aliados contra la soledad, el documento subraya que los riesgos —como la normalización de dinámicas afectivas con máquinas o la exposición a consejos peligrosos— superan cualquier beneficio potencial. "Sin salvaguardas robustas, estos servicios no son seguros para menores", concluyó Steyer.

El caso del adolescente fallecido ha impulsado demandas para regular el sector. Aunque las empresas insisten en que sus herramientas evolucionan, el estudio advierte que la autorregulación es insuficiente.

Mientras tanto, recomienda que padres y legisladores restrinjan el acceso a estas plataformas hasta que existan mecanismos verificables para proteger a los usuarios jóvenes.

© SomosTV LLC-NC / Photo: © Pavel Danilyuk-Pexels

Comentarios